Lors de ses voeux à la presse, le Président de la République a annoncé vouloir une loi sur les fake news. Dans cet article, je laisserai de côté deux aspects intéressants de la question : d’une part, l’aspect philosophique de savoir ce qu’est la vérité et si elle est atteignable, et d’autre part, l’aspect juridique de savoir qui doit décider de ce qu’on considère comme étant la vérité dans notre société démocratique. A la place, je vais vous raconter une histoire digne d’Hollywood, avec des espions russes, un savant fou, des hommes politiques à la ramasse et à la coiffure improbable, et un grand méchant dans l’ombre qui attend de rafler la mise.

Blame Russia

Si vous n’avez pas passé l’année 2017 dans une grotte coupée de la civilisation, vous devez avoir entendu parler des accusations d’intervention de la Russie dans la campagne électorale présidentielle américaine. Ces interventions auraient pris des formes variées :

- 400 personnes dans une « ferme à trolls » de Saint Pétersbourg passant leurs journées à soutenir Donald Trump sur les réseaux sociaux en utilisant divers techniques : création de mèmes et de vidéos, intimidation dans les fils de discussion, détournement d’information

- des pirates d’État attaquant l’équipe de campagne d’Hillary Clinton. John Podesta, qui avait rédigé un rapport sur la vie privée et le big data en 2014 pour Barack Obama, et Billy Rinehart du parti démocrate se sont fait prendre par un courriel d’hameçonnage dont la validité leur a été confirmée par un responsable informatique de la campagne. Si le reste de l’équipe Clinton était à l’avenant, je ne m’étonne pas trop de leur défaite – j’en reparle un peu plus bas. Toujours est-il que c’est grâce à ce piratage que les courriels internes de l’équipe Clinton ont fuité, donnant du carburant à la campagne Trump et accréditant la thèse d’amateurisme de l’ancienne secrétaire d’État née de l’affaire des courriels privés

- pour aggraver le tout, les courriels en question ont été sortis par wikileaks, après transmission par les espions russes, donnant plus de crédit et moins de teinte politique à la fuite

Le tableau semble complet et digne d’un film d’espionnage ; la plupart des médias ne parle que de cette filière russe dans les manipulations de l’opinion pour l’élection de 2016. Et quasiment aucun ne parle des deux personnages centraux de l’histoire, le savant fou et le génie du mal, et c’est pourtant d’eux que vient le vrai danger.

M. Brexit

En 2008, Michal Kosinski, un jeune chercheur polonais, est accepté à l’université de Cambridge pour y travailler au psychometrics center. Pour ses recherches, il utilisa Facebook pour créer une base de données de profils psychologiques sur la base de tests de personnalité ; il pensait obtenir les profils de ses potes de fac et de quelques unes de leurs connaissances, et finalement, il se retrouva avec des millions de profils donnés volontairement par des inconnus.

Loin de s’arrêter à ce premier exploit, il décida d’aller plus loin : comparer les profils psychologiques obtenus par cette méthode classique du questionnaire avec les like des participants. Comme les tests avaient pris la forme d’une application Facebook à laquelle les utilisateurs avaient donné le droit d’accéder aux like, c’était techniquement facile et autorisé par la plateforme – ça l’est toujours, j’y reviendrai. Sur la base de cette comparaison, il réussit à construire un outil créant un profil psychologique sur la base des like, partages et commentaires Facebook. Avec une soixantaine de like, en 2012 – il y a une éternité à l’échelle des progrès actuels des intelligences artificielles – cet outil pouvait déterminer la couleur de la peau avec 95 % de taux de réussite, l’orientation sexuelle avec 88 % de taux de réussite et l’affiliation politique avec 85 % de taux de réussite. Avec 300 like, Kosinski disait en savoir plus sur une personne que son conjoint, et avec encore plus, découvrir des tendances personnelles dont même l’individu n’était pas conscient – là aussi, j’y reviendrai.

En 2014, Kosinski fut approché par un certain Aleksandr Kogan pour utiliser ses recherches, dont il finit par comprendre qu’il travaillait pour une société dont le but était de manipuler les élections. Il refusa, tout en sachant très bien que ses recherches étant publiques, ce n’était que reculer pour mieux sauter. Comme quoi on est vraiment dans un James Bond, Aleksandr Kogan a officiellement changé son nom en Aleksandr Spectre, et étant donné qu’il a un doctorat, cela fait de lui le Docteur Spectre.

Quand après le brexit, on entendit parler d’une société nommée Cambridge Analytica ayant aidé par du ciblage psychologique fin les pro-brexit, tous les initiés britanniques de ces questions ont immédiatement pensé au Docteur Kosinski, qui dut expliquer qu’il n’y était pour rien, et qu’il avait même refusé de tels projets.

Vous me voyez venir : l’équipe de campagne de Donald Trump a utilisé les services de Cambridge Analytica, pour un montant total de l’ordre du million de dollars. Le principe était simple : créer des profils électoraux et politiques d’utilisateurs de Facebook dans les swing states, ces états qui peuvent basculer dans le camp démocrate ou républicain, et qui en général font ou défont les élections présidentielles, puis cibler ces gens avec des messages personnalisés pour faire changer leur vote. Comment Donald Trump a t’il gagné l’élection présidentielle ? Par des victoires surprises dans les swing states. Hillary Clinton, qui a pourtant passé sa vie dans la sphère politique américaine, et qui était opposée à un novice, s’est fait blouser sur l’aspect le plus battu et rebattu de l’élection présidentielle américaine, et son équipe de vainqueurs avec elle.

Vous n’avez pas entendu parler de cette version de la manipulation électorale de 2016, où ce ne sont pas des méchants russes qui tripatouillent les cerveaux, mais de bons américains bien de chez eux, Donald Trump et sa mèche à leur tête, Facebook en support bienveillant ? C’est normal, presque aucun média n’en a parlé, et pourtant des plaintes ont été déposées, et l’enquête officielle s’y intéresse. C’est moins vendeur, coco.

Le profilage en ligne, un risque pour la démocratie

Revenons maintenant à la loi sur les fake news souhaitée par notre Président. Outre le fait qu’en France on punit déjà la diffamation, la calomnie, et même la diffusion de fausses informations, j’affirme que les fake news ne sont pas un vrai problème. En effet, la solution est déjà connue, accessible à tous, et diffusée à notre jeunesse : questionner toute information un tant soit peu extraordinaire et apprendre à rechercher les sources. Je ne dis pas que c’est facile à faire, je ne nie pas le coût cognitif et en temps perdu induit par les solutions, mais se tromper est toujours plus coûteux que de vérifier, et non seulement on a déjà des solutions, mais de plus ces solutions ont des effets secondaires appréciables : renforcement de l’esprit critique, apprentissage de la méthode scientifique, accès à des questionnements philosophiques, etc.

Par contre, la méthode de Cambridge Analytica décrite ci-dessus est un vrai risque pour la démocratie : nul n’est besoin d’inventer des informations fausses, ni même de les caviarder. Il suffit pour se transformer en marionnettiste de l’opinion de choisir et pousser des informations vraies, vérifiables, mais bien sélectionnées pour être susceptibles de changer l’avis de la personne d’après son profil psychologique et politique, et ce sur le nombre limité d’électeurs ou de décideurs suffisant pour faire basculer un choix. Quand on lit le livre blanc de Facebook sur les influenceurs d’opinion, conséquence de l’enquête américaine, on constate que cette méthode n’est pas dénoncée ; il est d’ailleurs intéressant de noter dans ce document d’avril 2017 que les mesures envisagées par Facebook en collaboration avec les autorités sont miraculeusement alignées sur ce qu’a déclaré notre Président. A moins que la chronologie – et une pointe de mauvaise foi ? – ne nous pousse à dire que c’est l’inverse. Décidément, bien que seul le Danemark ait nommé un ambassadeur auprès des GAFA, il semblerait de plus en plus que ceux-ci interagissent avec les États d’égal à égal. Ne leur manque plus que la territorialité – enfin pour l’instant.

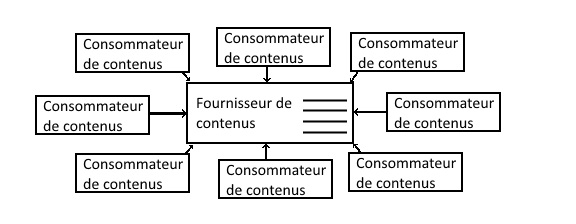

Cette non dénonciation de ces pratiques de profilage ne peut pas étonner ceux qui me lisent régulièrement : c’est le business model même de Facebook ! Quand certains écrivent que les journalistes sont gonflés de se plaindre des chauffards du bobard, alors qu’eux-mêmes n’en sont pas toujours exempts, je dis que Facebook serait gonflé de se plaindre du profilage de ses utilisateurs puisque c’est le gros de sa valeur capitalistique. Et on ne s’étonnera donc pas que les outils technologiques qui permettent ces méthodes – like, commentaires, partages accessibles aux applications tierces sur autorisation de l’utilisateur – existent toujours dans Facebook, et ne disparaîtront pas. Par contre, à coup de « meilleurs commentaires », Facebook s’érige de plus en plus en censeur, automatique bien sûr, et il devient de plus en plus difficile de mener des discussions complexes et argumentées dans les fils de commentaires.

Une solution partielle contre ces pratiques existe, la veille informationnelle (exemple), dont les principes sont de multiplier ses sources d’information et de penser volontairement contre soi-même en écoutant tout le monde, y compris des personnes pour lesquelles on a une aversion naturelle, mais d’une part, ce n’est qu’une solution partielle car les mécanismes mentaux qu’exploite Cambridge Analytica sont des biais cognitifs naturels de l’être humain, et qu’on en soit conscient ou non, on y reste sujet, et d’autre part, contrairement à l’application de la méthode critique, le coût cognitif est ici gigantesque : lire un maximum de sources prend un temps considérable, et s’infuser des contenus dont vous savez d’avance que les trois quarts vont vous faire sauter au plafond est exténuant. J’en sais quelque chose, je suis un libéral qui lit parfois le monde diplomatique !

Le profilage, un risque pour l’humanisme ?

Pour finir, j’aimerais élargir la réflexion sur ces conséquences du profilage au-delà des élections. Je ne pense pas que les intelligences artificielles soient proches d’acquérir la conscience – vous pouvez lire cet article lumineux sur la question – mais cela ne veut pas dire qu’elles sont sans risque. Les intelligences artificielles effectuent de mieux en mieux des tâches que l’humain fait naturellement : reconnaissance de la parole, des émotions, catégorisation d’objets dans des photos, analyse de dossiers, etc. Encore plus fort, comme évoqué ci-dessus, l’intelligence artificielle devient capable de déterminer des corrélations qu’aucun être humain ne serait capable de trouver, car elles impliquent de raisonner sur un volume d’information trop grand pour l’esprit humain.

La tentation est alors grande de laisser les intelligences artificielles prendre de plus en plus de décisions, l’argument, tout à fait rationnel, étant qu’elles prendront de meilleures décisions que les humains. Et c’est là qu’est le risque pour l’humanisme : si une intelligence artificielle nous connaît mieux que nous-mêmes, et prend de meilleures décisions pour nous que nous-mêmes, que nous reste t’il comme liberté ? Comment éviter la standardisation, comment conserver la créativité qui naît du chaos ? On pourrait penser que ce risque est aussi lointain que celui de voir Terminator sonner à notre porte, mais de nombreux indices laissent penser que non : la nourriture standardisée qui libère de la soit-disant tyrannie de la bouffe existe déjà et se vend plutôt pas mal, l’intelligence artificielle aide les analyses génétiques et l’association des médecins américains spécialistes de la fertilité considère que choisir un embryon sur la base d’un scoring génétique est à la fois justifié et éthique et l’amélioration de l’humain par des puces dans le cerveau est en marche.

Et si le risque n’était pas des manipulations grossières et aisément démontables pour qui est armé intellectuellement, mais des technologies et des usages qui sapent le fondement même de notre libre arbitre, et qui sont le business model de ceux à qui on va confier la surveillance ? M. le Président, recevez Eric Léandri, PDG de Qwant, ou Tim Berners-Lee, un des inventeurs du web, et pas Tim Cook, PDG d’Apple. Au lieu de négocier avec Facebook les couleurs du papier peint de la prison, faites péter ses murs.